Il est d’usage de considérer 4 champs d’application aux réseaux de neurones :

- la vision, le traitement d’images (classification, détection, segmentation, GAN, …)

- NLP, le traitement du langage naturel (traduction, classification, génération, …)

- embeddings pour les données structurées

- et les time series

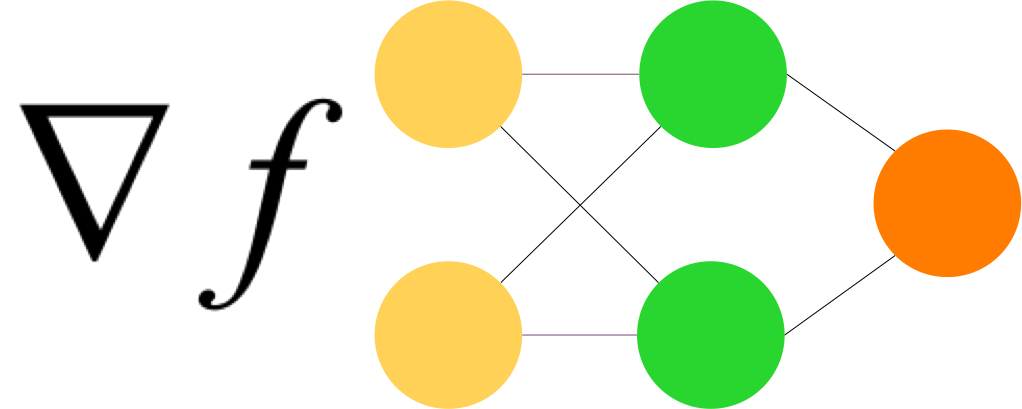

Le tutoriel présenté ici concerne les time series. Il s’agit de prévoir, de deviner la valeur du prochain élément dans une série temporelle. Il y sera question de RNN et LSTM.

Une série temporelle est générée, constituée de mouvements périodiques auxquels on ajoute de bruit.

L’exercice consiste à prédire, la prochaine valeur de cette série en s’appuyant sur diverses méthodes (naïve, linéaire, RNN simple, architecture RNN plus complexe, LSTM).

Le livre d’Aurélien Géron « Hands-On Machine Learning with Scikit-Learn and TensorFlow » est un must have de toute personne intéressée par le Machine Learning.

C’est un livre très dense, bien construit, à jour, complet et bien écrit.

Par ailleurs, ce livre est accompagné de notebooks Jupyter, codés en Python 3, avec TensorFlow 2.x.

Le tutoriel présenté ici est le sien, complété de quelques commentaires afin d’expliciter certains points.

Le code originel est sur GitHub, ici.